Sensor-Technologie: Was Sie in der Praxis von Ihrem Sensor erwarten können

Die meisten Sensoren heutzutage basieren auf einer einheitlichen Bauweise. Dies bringt neben Vorteilen jedoch auch Nachteile mit sich, die sich auf den Fotos widerspiegeln. Die Hersteller versuchen daher, eine bessere und funktionellere Alternative zu finden, mit der diese Mängel verringert werden können. Lesen Sie hier, wie sich die einzelnen Lösungen unterscheiden und was Sie von Ihrem Sensor erwarten können.

Natürlich ist es nicht notwendig, die Technologie bis ins letzte Detail zu kennen, aber eine allgemeine Kenntnis wird Ihnen sicherlich helfen. Zum Beispiel, wenn Sie eine neue Kamera kaufen oder wenn Sie seltsame Fehler auf Ihren Bildern finden, die durch Sensoren verursacht wurden.

Ein typischer Sensor von heute

Die überwiegende Mehrheit der Technik, ob dedizierte Kameras oder Mobiltelefone, verwendet einen CMOS-Sensor (Complementary Metal Oxide Semiconductor), der Ende der 1960er Jahre erfunden wurde.

Jeder Chip enthält Millionen von Zellen/Pixeln, die Licht in Elektronen umwandeln können. Nachdem das Bild aufgenommen wurde, befindet sich in jeder Zelle eine akkumulierte Ladung, die abgelesen wird, um festzustellen, wie viel Licht an die jeweilige Stelle gefallen ist.

Es sieht einfach aus, aber es gibt einen Haken. Dieses System kann nämlich von selbst keine Farben erkennen.

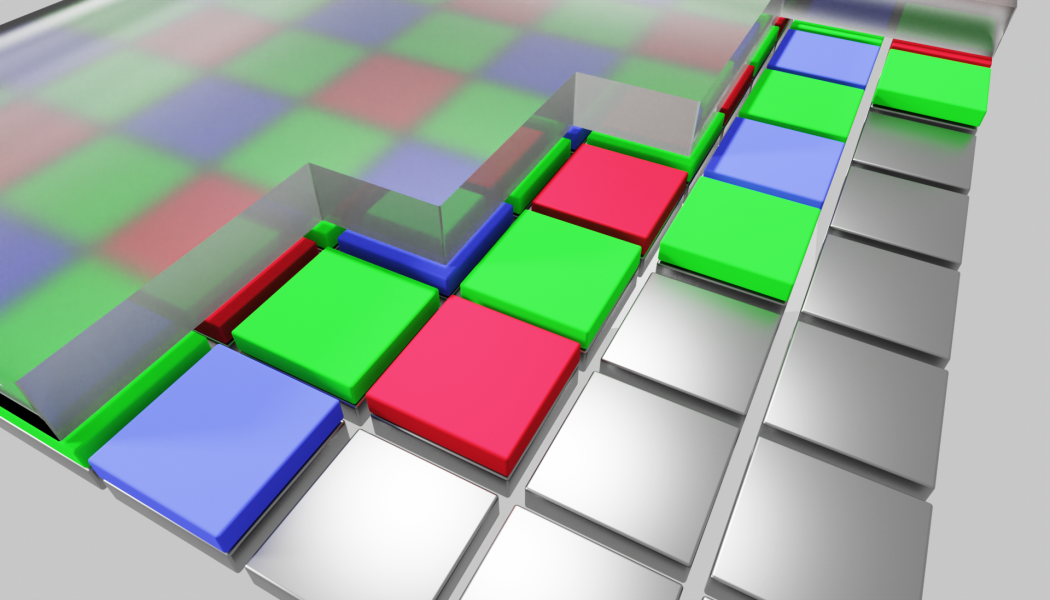

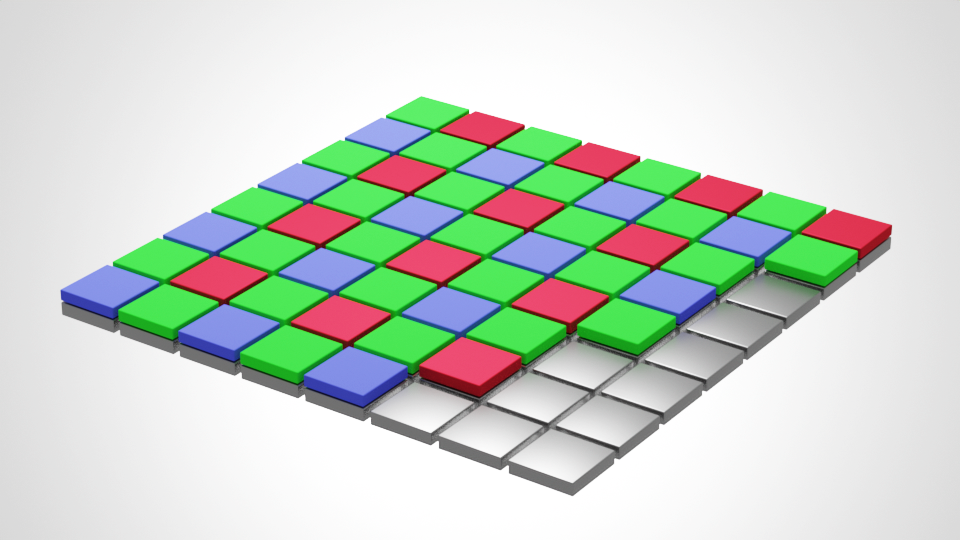

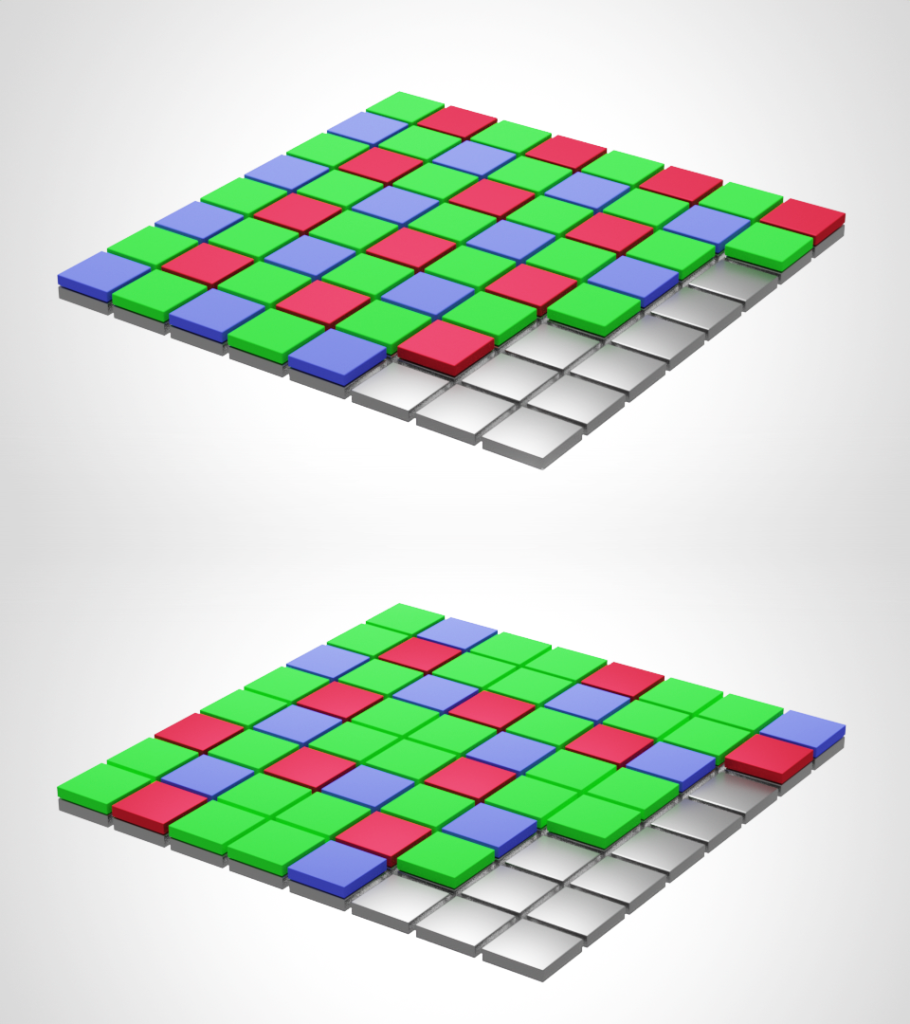

Daher wird ein nach seinem Erfinder benannter Trick verwendet, der sogenannte Bayer-Filter oder die Bayer-Matrix. Vor jeder Zelle befindet sich entweder ein Rot-, Grün- oder Blaufilter, der nur das Licht der jeweiligen Farbe durchlässt. Zusammen bilden die Filter ein regelmäßiges Gitter von Zellen, in denen jede auf unterschiedliche Lichtfrequenzen reagiert.

Somit hat jedes Pixel Daten von nur einer Farbe und die verbleibenden zwei werden später von den benachbarten Zellen errechnet. Somit würden wir vom Sensor im obigen Bild ein Foto von 8 x 8 Pixeln erhalten.

Sie können feststellen, dass die roten und blauen Zellen ungefähr die gleiche Anzahl aufweisen, die grünen jedoch doppelt so viele. Dies liegt daran, dass das menschliche Auge bei weitem am empfindlichsten für Grün ist. Daher ist es sinnvoll, so viele Informationen darüber, wie möglich zu erfassen.

Vor dem CMOS-Sensor kämpfte der CCD-Sensor um seine Position an der Sonne. Er funktioniert nach einem ähnlichen Prinzip, die Informationen werden nur unterschiedlich gelesen (eher einzelne Pixel als Zeilen). Heute wird er nur noch ausnahmsweise in bestimmten Geräten eingesetzt.

Probleme des Bayer-Filters

Der beschriebene Sensor hat viele nette Eigenschaften, aber es gibt auch ein paar dunkle Seiten:

- Reduzierte Auflösung

- Lichtverlust

- Aliasing (verfälschte Farben u.ä.)

Reduzierte Auflösung

Den Sensor aus dem obigen Bild würde man als denjenigen bezeichnen, der 64-Pixel-Bilder erzeugt. Dabei erfasst er jedoch nur etwa ein Drittel der Informationen und berechnet den Rest.

Die genannte Auflösung ist daher irreführend. Wenn Sie über ein 30-Megapixel-Gerät verfügen würden, müsste er intern mit Zellen auskommen, die etwa 10 Megapixeln entsprechen (wenn auch schlau verteilt).

Lichtverlust

Die winzigen Farbfilter führen dazu, dass das Licht, das zwar auf den Sensor, aber auf ein Pixel mit falscher Farbe in der Bayer-Matrix trifft, vergessen wird. Der Sensor registriert dies nicht einmal.

Es wird berichtet, dass dadurch etwa 50% des Lichts verloren gehen. Wenn wir einen Weg finden würden, diese verworfenen Informationen zu verarbeiten, würde das Rauschen reduziert und das Aufnehmen bei gedämpftem Licht etwas einfacher.

Aliasing

Das letzte Problem ist das schwierigste. Die Bayer-Matrix arbeitet perfekt mit Farben in monolithischen Farbbereichen – sie überprüft regelmäßig die Werte von Rot, Grün und Blau und berechnet (interpoliert) sogar die fehlenden Stellen, um einen schönen Bereich mit einem gleichmäßigen Farbverlauf zu erzeugen.

Dieses Prinzip versagt jedoch, wenn es auf eine feine, regelmäßige Struktur stößt, in der sich die Farben schnell ändern. Ein typisches Beispiel ist ein Kleidungsstück mit feinen Fäden, das entweder völlig neue Muster oder falsche Farben erzeugt. Diesen Effekt nennt man Moiré.

Aliasing tritt eher bei regelmäßigen, menschlichen Strukturen auf (gewebte Stoffe, entfernte Wolkenkratzer), als beispielsweise bei Landschaftsfotografien.

Wie Hersteller Aliasing lösen

Die oben beschriebenen Probleme nehmen wir mit dem bloßen Auge größtenteils nicht wahr. Dies liegt daran, dass die Hersteller bereits über diese Fallstricke nachgedacht haben und in der Regel eine Folie direkt vor der Bayer-Matrix verwenden, um das Bild leicht zu verwischen. Dadurch gelangen auch feine Strukturen an die benachbarten Pixel und werden im gesamten Farbspektrum aufgezeichnet. Diese Folie wird als Tiefpassfilter bezeichnet und ist in den meisten Kameras zu finden.

Der Nachteil ist klar: Bilder könnten ohne diesen Filter schärfer sein.

Da die Anzahl der Megapixel zunimmt, verringert sich das Problem des Aliasing. Daher haben einige Hersteller entschieden, dass der Benutzer bei einigen Modellen entscheiden kann, ob er eine Variante mit oder ohne Filter (oder einen anderen Filter, der Verwischeffekt ausgleicht) kaufen möchte. Dies gilt zum Beispiel für die Nikon D800 und D800E (36 Megapixel, die zweite Variante ist ohne Filter) oder Canon 5DS und 5DS R (50 Megapixel, die zweite Variante ist ohne Filter).

Der extremere Ansatz wurde von Leica mit dem Modell M Monochrom verfolgt, das weder einen Tiefpassfilter noch eine Bayer-Matrix enthält und Bilder in reinem Schwarzweiß aufnimmt. Dadurch entfällt nicht nur das Problem mit verfälschten Farben, sondern auch andere Probleme mit der Bayer-Matrix, d.h. Lichtverlust und Auflösungsverlust. Natürlich können wir dadurch nur monochromatisch fotografieren.

Fujifilm hält an einer milderen Lösung fest. Er verzichtet auf den Tiefpassfilter und ersetzt die ursprüngliche Bayer-Matrix durch seinen X-Trans-Filter. Über den Pixeln sind einzelne Farben leicht schattiert, wodurch weniger regelmäßige Strukturen entstehen und große Farbfehler vermieden werden.

Pentax verfügt über ein elegantes System, die einen Bayer-Sensor ohne Tiefpassfilter verwendet. Wenn der Benutzer den Unschärfefilter für angemessen hält, schaltet er den Menüschalter um und die Kamera verwendet sein Stabilisierungssystem, um den Sensor während der Aufnahme leicht zu schütteln. Dies sind Erschütterungen, die kleiner als ein Pixel sind. Dies reicht aus, um Aliasing zu vermeiden. Wenn maximale Schärfe benötigt wird, kann der Effekt wieder ausgeschaltet werden.

Zunehmend verbreitet sich auch die Möglichkeit, ein ursprünglich für die Sensorstabilisierung entwickeltes System zu verwenden, um schnell mehrere Aufnahmen zu machen, die genau 1 Pixel in verschiedene Richtungen verschoben sind. Die Bilder werden sofort miteinander kombiniert, um Informationen zu allen Farben auf jedem Pixel zu erhalten. Manchmal wird auch die Auflösung auf ähnliche Weise erhöht. Suchen Sie nach dieser Lösung unter dem Namen Multi-Shot.

Viele sichtbare Aliasing-Fehler können auch durch Bearbeiten mit dem PC behoben werden. Natürlich ist es aber unpraktisch und zeitaufwendig, viele ähnlich betroffene Bilder zu verwalten.

Foveon

Es gibt auch andere konzeptionelle Sensoren als CMOS mit Bayer-Filter. Ein Beispiel ist Foveon von Sigma, das alle Farben in jedem Pixel erfasst. Dabei wird das Prinzip angewendet, dass unterschiedliche Lichtfrequenzen beim Durchgang durch lichtempfindliches Silizium in unterschiedliche Tiefen vordringen. Jedes Pixel besteht aus drei gestapelten Zellen mit jeweils einer genau abgestimmten Dicke. Licht geht nicht nur in sie hinein, sondern auch durch sie hindurch. Nur die rote Komponente dringt in die unterste ein, die mittlere in Rot und Grün und die höchste Zelle erfasst alle Farben, einschließlich Blau. Der konkrete Wert der einzelnen Farbkomponenten wird durch einfache Mathematik berechnet.

Dieses System ist aber bisher noch nicht eindeutig besser als die üblicherweise verwendeten Sensoren. Trotz besserer Farbdetails werden mehr Rauschen und kleine Farbungenauigkeiten erzeugt.

Auch hier ist es wichtig, die Auflösung zu betrachten, da der Hersteller eine ähnliche Mathematik verwendet und jedes Pixel dreimal multipliziert, um mithilfe des Bayer-Filters Marketing-Zahlen der anderen einzuhalten. Die angekündigte 60-Megapixel-Kamera hat tatsächlich „nur“ 20 Millionen Pixel mit jeweils drei Zellen untereinander für unterschiedliche Farben.

Lytro

Als eine Besonderheit möchte ich Geräte der Firma Lytro erwähnen. Sie verfügten über einen Sensor, der nicht nur die Menge des Lichts in jedem Pixel erfasste, sondern auch die Richtung, aus der es kam. So konnte es die Tiefe bestimmen und zum Beispiel erst nach der Aufnahme auf einen beliebigen Bildteil fokussieren.

Für gewöhnliche Nutzer wurden nach und nach zwei relativ obskure Geräte hergestellt. Dann stieg das Unternehmen in die Filmbranche ein. Aber selbst das scheiterte und das Unternehmen stellte die Entwicklung ein.

Alles verbessert sich

Nun haben wir die Hauptprinzipien fotografischer Sensoren beschrieben. Die Hersteller bemühen sich jedoch weiterhin und verbessern neben dem eigentlichen Prinzip auch die Elektronik hinter den Pixeln. Sowohl die, welche die Daten von der Szene erhält, als auch die, welche die Informationen verarbeitet. Das ist der Grund, warum wir immer bessere Bilder bekommen. In Verbindung mit Computerfotografie und Leistung, die in winzigen Geräten verborgen ist, können wir uns immer noch auf Einiges freuen.

Matthias Peters

Danke für Deine Infos. Ich muss aber eine kleine Korrektur loswerden: die Verschlechterung der Auflösung durch das Bayer-Pattern liegt lediglich bei ca. 18%. Das konnte ich empirisch ermitteln, in dem ich Bildaufnahmen mit zwei Industrie Kameras mit einem Sony IMX264 Sensor, 1x Monochrome-Kamera, 1x Farbkamera verglichen habe.

Dazu habe ich die Ausllesung eines grenzwertigen Datamatrix-Codes konfiguriert und geprüft, wie ich den Arbeitsabstand verändern musste, um mit beiden Kameras auf die gleiche Leserate zu kommen.

Das Ergebnis: Mit der Farbkamera musste ich eine 18% höhere Auflösung haben um auf die gleiche Leserate zu kommen, wie mit der S/W Kamera.

Vít Kovalčík

Sorry for answering in English. The article was translated by a professional translator, but my German is very basic. And from the results of auto translation of your comment, I am not sure I want to risk the auto translation the other way round 🙂

Anyway, thank you for the information! That is new to me and I believe you, however at the same time I think the loss of resolution will depend on the scene. If we imagine a scene consisting only of the blue color then Bayer sensor will essentially have 75 % of its (sub-)pixels black and only those remaining 25 % blue ones will be relevant. On fine patterns in the scene this will definitely mean some serious resolution loss.